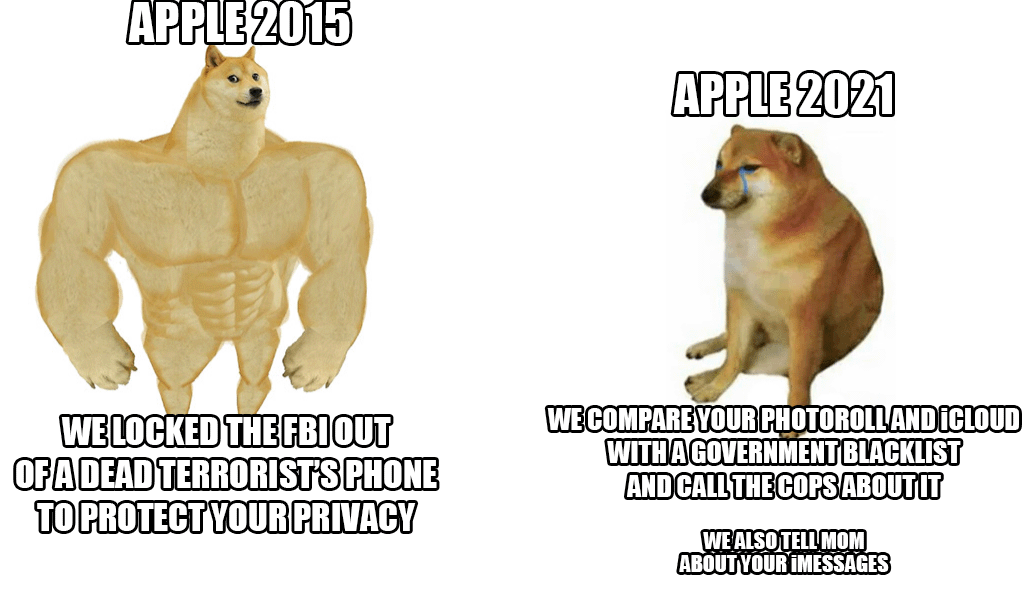

A finais da semana pasada, Apple presentou un novo sistema contra o abuso infantil que escaneará practicamente as fotos de iCloud de todos. Aínda que a idea soa ben a primeira vista, xa que os nenos realmente necesitan estar protexidos desta acción, o xigante de Cupertino foi criticado por unha avalancha, non só de usuarios e expertos en seguridade, senón tamén de filas dos propios empregados.

Segundo a información máis recente dunha axencia respectada Reuters unha serie de empregados expresaron as súas preocupacións sobre este sistema nunha comunicación interna en Slack. Supostamente, deberían ter medo de posibles abusos por parte de autoridades e gobernos, que poderían abusar destas posibilidades, por exemplo, para censurar persoas ou grupos seleccionados. A revelación do sistema provocou un forte debate, que xa conta con máis de 800 mensaxes individuais dentro do citado Slack. En resumo, os empregados están preocupados. Mesmo os expertos en seguridade xa chamaron a atención sobre o feito de que en mans equivocadas sería unha arma realmente perigosa usada para suprimir os activistas, a súa mencionada censura e similares.

A boa noticia (ata agora) é que a novidade só comezará nos Estados Unidos. Polo momento, nin sequera está claro se o sistema tamén se utilizará dentro dos estados da Unión Europea. Non obstante, a pesar de todas as críticas, Apple mantén por si mesma e defende o sistema. Argumenta sobre todo que toda a comprobación ten lugar dentro do dispositivo e unha vez que hai unha coincidencia, só nese momento o caso é revisado de novo por un empregado de Apple. Só ao seu criterio será entregado ás autoridades competentes.

Podería ser interesache

Non me gustaría cambiar de iCloud a algo seguro e verdadeiramente privado, pero se Apple insiste, deixarei de pagarlles de todos os xeitos.

Estará activo (polo momento) só nos EUA

Realmente non importa onde se aplicará lexislativamente. Esa tecnoloxía xa estará aí fóra e implantada. Ese é o maior risco.